Zenlayer 推出 AI 模型全球调用解决方案,破局企业部署三大挑战

6月19日-20日,在云计算领域行业年度盛事——亚马逊云科技中国峰会(AWS Summit) 在上海世博中心盛大举行。作为本届峰会银牌赞助商,Zenlayer 携最新 AI 基础设施解决方案亮相,通过专属展台全方位展示最新产品成果。

在6月20日“合作伙伴开放麦”环节中,Zenlayer 高级解决方案架构师郭天铭发表主题演讲《AI 全球化调用与 Token 传输优化》,深度剖析当下企业 AI 部署痛点与破局之道。

AI 模型调用时代的三大挑战:协同难、延迟高、开销大

当前大模型的核心发展趋势存在三个关键方向:多模态融合、多模型协同以及 RAG 架构普及。

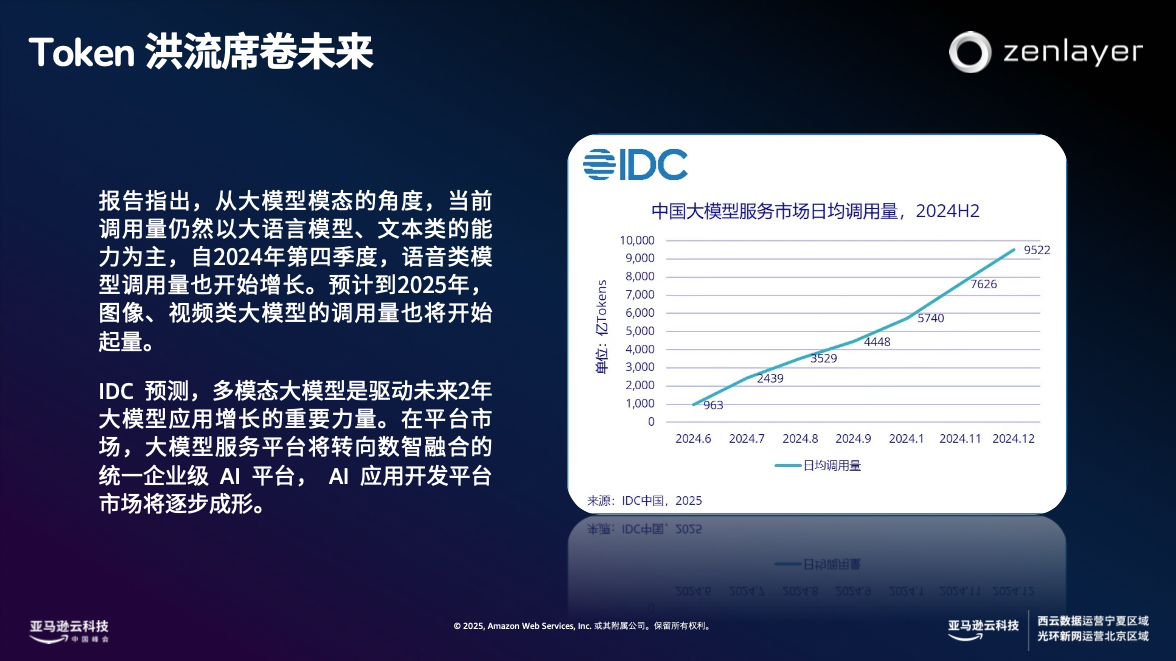

IDC 预测,多模态大模型是驱动未来 2 年大模型应用增长的重要力量。在平台市场,大模型服务平台将转向数智融合的统一企业级 AI 平台,多模型协同逐渐成为 AI 应用主流场景。而为了降低 AI 幻觉、提升数据输出的准确度,RAG 架构逐渐成为 AI 部署的标配。

在这一趋势下,AI 的能力虽然得到提升,却以复杂度、成本与延迟为代价,企业部署 AI 时挑战重重:

1. 模型接入与管理困境

• 多模型接入复杂:不同模型的 API 接口、数据格式、调用方式各异,开发和集成的工作量成本巨大。

• Token 成本激增:据估算,一家中型企业每月调用大模型的 Token 数量可达千万级,仅Token 调用曾本就可能高达数万美元。

• 跨境延迟与卡顿:数据传输延迟严重,例如从中国调用美国的 OpenAI 模型,平均延迟高达 200ms 以上,网络不稳定将进一步引发业务中断风险。

• 系统集成与分散计费:需解决数据安全、权限管理等集成难题,且需对接多个服务商计费系统,管理负担沉重。

2. RAG 场景的叠加挑战

• 链路更长,延迟增加:RAG 架构的多跳通信显著延长响应时间

• Token 消耗倍增:需要拼接大量上下文,Token 消耗通常是普通对话的 3-5 倍甚至更高

郭天铭指出,企业必须具备“就近处理 + 高质量传输 + 多模型协同”的能力,方能破解上述难题。

Zenlayer AI Gateway:让 AI 模型调用更丝滑

针对行业痛点,Zenlayer 创新推 Zenlayer AI Gateway 解决方案,通过整合全球超连接网络与 Zenlayer AI Gateway 平台,为企业打造端到端的 AI 部署优化方案。该方案已助力某头部社交平台实现开发运维成本降低 20%。

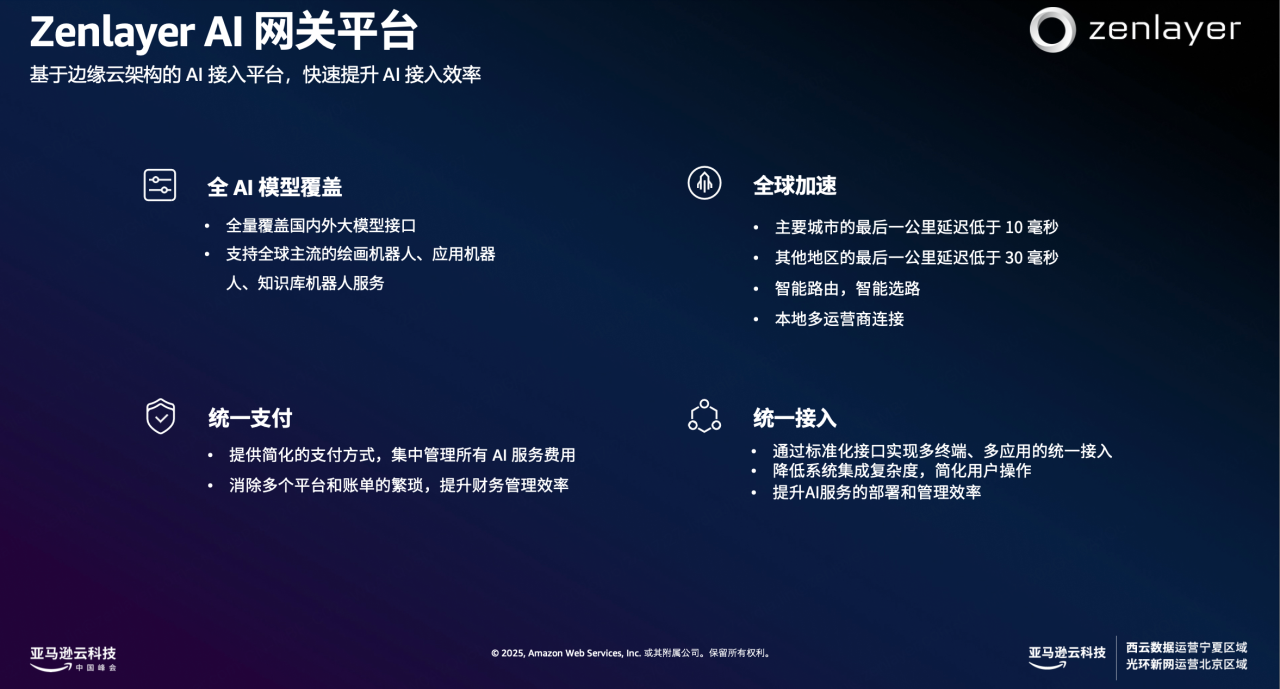

Zenlayer AI Gateway 是 Zenlayer 推出的新一代 AI 加速平台,它通过统一接口大幅提升了 AI 模型调用效率。该产品具备四大核心功能:

1. 统一接入,无缝切换

集成全球主流 AI 模型(如OpenAI、Claude、Amazon Bedrock、国产模型、开源模型等),通过标准化接口统一接入

支持模型一键切换、混合调用(主备/灾备),大幅降低多模型接入的开发和运维复杂度。

2. Token 传输优化

对重复请求进行语义缓存,减少重复 Token 消耗,尤其适用于 RAG、多模型混合调用等高 Token 场景。

3. 全球网络加速

在多区域场景中(如法兰克福、洛杉矶、新加坡),1M Token 请求经公网传输平均耗时约 3600 ms,而通过 ZGA 边缘加速可优化至约 700ms 左右,实现 80% 的性能提升,显著提升全球范围内的 AI 响应速度与稳定性。

4. 企业级安全与部署灵活性

支持私有化部署,集成企业认证、权限控制及内容过滤,保障数据安全。

可加速调用 Amazon 云服务(Lambda/SageMaker/Bedrock),优化混合云 AI 应用体验。

展望未来,面对多模型协同与 RAG 普及的大趋势,Zenlayer 将依托自身广泛的全球网络优势,不断迭代 Zenlayer AI Gateway 产品,为企业提供更灵活、高效、经济的 AI 模型全球化调用与 Token 优化解决方案。

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。